Эволюция российского веб-спама: опыт компании «Яндекс»

наш канал в

наш канал в  ЯНДЕКС.ДЗЕН.

ЯНДЕКС.ДЗЕН.

1. ВВЕДЕНИЕ

Так как поисковые системы (ПС) изначально используют содержание веб-страницы в качестве главного источника ранжирующего сигнала, контентный спам стал одним из наиболее широко распространенных типов спама. Спамеры пытаются влиять на такие факторы ранжирования, как TF/IDF или BM25, создавая тексты (часто бессмысленные) с оптимальной частотой ключевых слов. Обнаружением спама этого типа главным образом занимаются подходы, базирующиеся на модели языка [4], [8].

Как только поисковые системы начали использовать ранжирующие признаки, основанные на ссылках, такие как Page Rank, спамеры стали влиять на эти факторы с помощью обмена ссылок, непотических ссылок, платных ссылок и других искусственных механизмов формирования ссылок. Большинство подходов по обнаружению ссылочного спама основано на разнообразных свойствах веб-графов [1], [11].

Применение информации о пользовательском поведении при ранжировании приводит к появлению соответствующих методов спама, таких как кликфрод (скликивание). Существуют некоторые алгоритмы по обнаружению спама, основанного на поведении пользователя [6], [9].

Исходя из нашего опыта, мы знаем, что любой фактор, используемый при ранжировании, может быть использован для получения лучшей позиции при ранжировании. Спамеры серьезно замотивированы обнаруживать и использовать различные виды накруток. Таким образом, разработчики поисковых систем всегда должны учитывать эти намерения при проектировании и внедрении новых признаков и алгоритмов ранжирования.

Эта статья построена следующим образом: Раздел 1 описывает инфраструктуру антиспама Яндекса, которая позволяет быстро реагировать на возникающие угрозы. Во втором разделе мы кратко описываем главные типы веб-спама и показываем, как поисковые системы реагируют на эти явления. Раздел 3 посвящен проблеме агрессивной рекламы, которая связана с опытом и удовлетворением пользователей. В четвертом разделе идет речь о становящейся все более очевидной тесной связи между веб-спамом, вредоносным программным обеспечением и социальной инженерии. Заключение и нерешенные насущные проблемы представлены в Разделе 5.

2. ИНФРАСТРУКТУРА АНТИСПАМА

Количество веб-страниц в Интернете огромно, таким образом, поисковые системы должны обрабатывать документы очень быстро. Яндекс хранит больше чем 20 миллиардов документов в своем поисковом индексе и обходит более 3 миллиардов документов каждый день. Некоторые документы подвергаются специальной обработке с интерпретацией JavaScript и полному рендерингу контента. Мы спроектировали и внедрили специальный язык, основанный на регулярных выражениях, для создания различных классификаторов контента. Этот язык используется в системе быстрой классификации, которая может обрабатывать 200 000 документов в секунду. На основе этих технологий были разработаны несколько классификаторов с высокой точностью и полнотой. Классификаторы контента основаны на правилах, которые могут быть легко написаны аналитиком без сильных навыков программирования (см. рисунок 1)

Эти правила используются в качестве слабых классификаторов, которые затем внедряются в качестве отличительных признаков для gradient boosted decision trees [5] в алгоритмы обнаружения веб-спама. Существует огромное количество собранных данных, касающихся доменов, текстов, ссылок, кликов, поведения анонимных пользователей и т.д., которые могут быть использованы для развития признаков ранжирования. Кроме использования непрерывно обновляемого набора маркированных данных, подготовленных группой профессиональных асессоров, наш алгоритм обучается на обратной связи, которую получает и обрабатывает каждый день наша техническая поддержка. Подобная обратная связь позволяет своевременно узнавать о новых тенденциях появления спама и других типах мошенничества.

TUE_POP_QUERY_WEIGHT ::= TUR_POP_QUERY_P.total_weight;

TUE_POP_QUERY_P ::= top_freq-params(

filter=doc_filter (iang="TUR", words_in_doc>=100, ta.g="p"), weight_dict=dict(src_file="tur_popular_guexies.diet"),

words_in_shingle = 1);

TUR_POP_QUERY_WEIGHT_AVG ::= avg(TUR_POP_QUERY_WEIGHT);

TUR_POP_QUERY_WEIGHT_AVG_DOC ::=

on site TUR_POP_QUERY_WEIGHT_AVG;

Рисунок 1: TUR_POP_QUERY_WEIGHT_AVG_DOC – особенность документа «средний вес в словаре популярных турецких запросов»

3. ФОРМЫ ВЕБ-СПАМА

Далее в статье мы продолжаем рассматривать методы спама от самых простых до более сложных. Мы описываем развитие веб-спама и SEO с технической точки зрения, а также обсуждаем их социальное воздействие.

3.1 Тексты

Обычная «оптимизация» основана на накрутке TF/IDF и состоит из экспериментирования с терминами, частотой употребления и размещением их на странице методом проб и ошибок. Подобное искусственное размещение термина часто приводит к ухудшению качества контента страницы и значительно портит отношение пользователей. Таким образом, излишняя текстовая оптимизация должна контролироваться ПС, а признаки ранжирования текста требуют тщательной настройки.

3.2 Доменные имена

Влияние большого веса доменных факторов показано ниже. Простейшая уловка заключается в использовании домена с именем, которое содержит слова продвигаемого запроса. Это может выглядеть странно, но использование такой техники для получения прибыли легко делает все результаты поиска для определенного запроса неразличимыми (каждое доменное имя в выдачесодержит основу запроса).

3.3 Ссылки

Покупка ссылок у ссылочных брокеров является одним из самых популярных методов ссылочного спама в России. К сожалению, эта практика является довольно обычным делом по причине задержек в реакции поисковых систем. В течение долгого времени, когда купленные ссылки являлись эффективным способом продвижения сайта, эта техника получила широкое распространение, что демонстрирует насущную необходимость ПС очень быстро реагировать на новые формы спама. Мы полагаем, что быстрая реакция поисковой системы на новый тип спама часто более важна, чем алгоритм выдачи результатов поиска.

Мы разработали эффективный алгоритм, который объединяет анкорную текстовую классификацию и анализ графа для обнаружения купленных ссылок [7]. Классификатор купленных ссылок помогает по-разному вычислять факторы ссылочной релевантности для коммерческих и некоммерческих запросов. Это позволяет усовершенствовать алгоритм ранжирования для улучшения качества поиска, уменьшать влияние SEO на некоммерческие запросы и увеличить разнообразие выдачи ПС. Важно заметить, что купленные ссылки легко классифицировать, что позволяет ПС управлять качеством поиска и бороться со спамом, сосредоточенным на коммерческих запросах. Но необходимо отметить, что понятие приобретения ссылок прочно укоренилось в российском сегменте сети из-за замедленной реакции ПС.

Рисунок 2: Процент коммерческих предложений в топе уменьшился, разнообразие результатов поиска на сервисных запросах значительно увеличилось (см. analyzethis.ru)

3.4 Поведение пользователя

Так как поведение пользователя также является хорошим источником ранжирующего сигнала [2], спамеры начали заниматься исследованиями по его накрутке. Они не знают, как вычисляются и работают кликовые факторы, но обоснованно предполагают, что CTR действительно играет важную роль. Наиболее распространенная используемая техника заключается в том, чтобы найти веб-сайт в ПС и начать кликать на него. Следующий шаг прямой: создать сообщество, использующее модель Pay-Per-Action, где недорогостоящие рабочие выполняют запрос ПС и кликают на результаты согласно инструкциям. Ситуация стала еще хуже, когда такие действия начали становиться автоматическими, с использованием ботнетов. Кликфрод в настоящее время – один из худших методов продвижения сайта, который оказывает серьезное негативное воздействие на целую интернет-экосистему. Именно поэтому поисковые системы должны отслеживать любую попытку кликфрода максимально быстро и эффективно. Чтобы уменьшить влияние SEO на качество поиска, Яндекс штрафует веб-сайты, пытающиеся мошенничать с данными о кликах, а также ограничивает воздействие кликовых факторов ранжирования для коммерческих запросов.

Как мы видим, существует несколько «векторов атаки», которые должны контролироваться ПС. Соответствующие классификаторы и ограничения разработаны в Яндекс для минимизирования эффекта этих атак. Из-за активных противодействий со стороны ПС спамеры непрерывно ищут новые методы обмана. Так как ПС разработали эффективные алгоритмы анализа контента, ссылок и кликов, «черные» оптимизаторы перешли в области, которые не были хорошо исследованы ПС – спам динамического контента. Javascript и Actionscript позволяют добавлять что-либо к интернет-странице. HTML-индексирование обычно не предоставляет ПС информацию о том, как будет выглядеть страница после интерпретации JS-кода. Это делает возможным развитие новых методов веб-спама, которые труднее обнаружить.

4. АГРЕССИВНАЯ РЕКЛАМА

Качество результатов – наиболее важная характеристика для поисковой системы и она оказывает прямое влияние на ее популярность. Существует много методов оценки качества поисковых систем [3]. Методы оценки качества, основанные на автоматическом анализе пользовательского взаимодействия с поисковой системой (пользовательские лог-файлы), важны для транзакционных запросов. Однако ручная оценка транзакционных запросов является более сложной, требует большего количества времени и поэтому более дорогая.

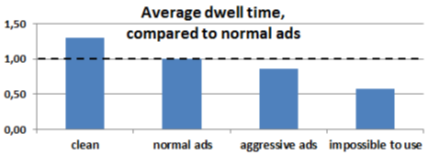

Один и тот же мультимедийный контент, файлы, программное обеспечение и т.д. могут быть найдены на многих различных веб-сайтах. Хотя существует множество релевантных страниц, которые позволяют пользователям загружать файл или смотреть видеофильм, который он искал, это не означает, что все они одинаковы для пользователя. Например, развлекательный сайт, который предоставляет интересное содержание, может поместить рекламу для получения прибыли. Однако его жадность может привести к широкому использованию рекламы, что сделает этот веб-сайт очень недружелюбным или непригодным для пользователя, так как требуемое содержание часто становится почти недоступным в таком случае. В нашем исследовании влияния рекламы на поведение пользователей мы использовали «продолжительность пребывания» – широко известную метрику[2], которая позволяет нам оценить удовлетворение пользователей интернет-страницей. Мы попросили нашу службу оценки качества поиска оценить 53 200 URL и собрали 93 900 результатов оценки. Было получено 4 типа оценок: страница без рекламы, страница с нормальным содержанием рекламы, страница «невозможно использовать» и спам (102 URL со спамом были удалены, также были удалены 2107 страниц с кодом 404). 370 веб-сайтов из 16000 (2,3%) содержали страницы, которые были оценены как «невозможно использовать». Результаты измерений «продолжительности пребывания» показаны на рисунке 4.

Рисунок 3: Средняя «продолжительность пребывания» зависит от объема объявлений на веб-сайте

Можно заметить, что веб-сайты с неоправданным количеством рекламы могут вызывать отвращение и жалобы от пользователей. Средняя «продолжительность пребывания» для «замусоренных» сайтов составляет в 1,7 раза меньше, чем для «чистых». Необходимо отметить, что эта разница во времени также зависит от популярности сайта. Различие между средней «продолжительностью пребывания» для нормальных и «замусоренных» веб-сайтов уменьшается с ростом популярности. Это приводит нас к более тщательным действиям относительно известных и популярных веб-сайтов, если мы не хотим уменьшать удовлетворение пользователей.

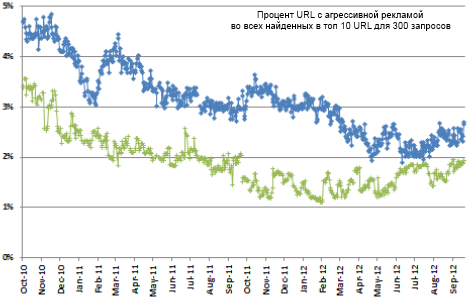

Существует алгоритм, применяемый в Яндексе для обнаружения подобной агрессивной рекламы, а также алгоритм оптимизации средней «продолжительности пребывания». Алгоритм выбирает веб-страницу без агрессивной рекламы из нескольких результатов с подобным контентом и отдает ей предпочтение. Использование этого алгоритма приводит к более высокой удовлетворенности пользователей для результатов транзакционного запроса. Такая стратегия вынуждает веб-мастера принять решение – получить трафик из поисковой системы или продолжить чрезмерно использовать рекламу, что делает не работающим подход «давайте создадим много дешевых, но оптимизированных веб-сайтов с пиратским контентом и очень агрессивной рекламой» (например, поисковый спам – дорвей). Таким образом, число агрессивно монетизированных веб-сайтов значительно уменьшилось, несмотря на некоторые попытки, предпринятые их веб-мастерами для сокрытия рекламы от поисковых систем в HTML с помощью обфускации (запутывания кода) и других уловок (см. рисунок 5).

Рисунок 4: Число сайтов с агрессивной рекламой в российской части сети уменьшилось в 2 раза за 2 года

Как мы видим, ПСв состоянии обнаружить агрессивную рекламу в динамическом контенте. Эта способность увеличивает риск «черных» оптимизаторов потерять трафик от ПС. Таким образом, спамеры сталкиваются с проблемой оптимизации: как увеличить эффективность баннера? Использование социальной инженерии и вредоносного программного обеспечения стало следующим шагом в веб-развитии спама.

5. ВЕБ-СПАМ, ПОДДЕЛКИ, ФАРМИНГ

Сервисы микроплатежей (SMS-платежи) являются основой для подпольной экономики российского Интернета. Например, целевые страницы с проплаченной мобильной подпиской – это один из самых прибыльных способов делать деньги с помощью черного SEO. [10]. «Черные» оптимизаторы создают очень запутывающую схему, когда не ясно, кто отвечает за операционные затраты: у оператора мобильной связи есть несколько крупных партнеров (контент-провайдеры и поставщики услуг), у его партнеров есть свои собственные партнеры и так далее. Независимо от того, как конкретно все организовано, это чрезвычайно прибыльно для «черных» оптимизаторов, если пользователь соглашается на подписку или отправляет платную SMS. В большинстве случаев, «черный» трафик идет в форме подписки с неясным или нечитабельным текстом соглашения, предназначенным для запутывания пользователей. Социальная инженерия широко используется для увеличения количества подписчиков. Неопытные пользователи больше доверяют знакомым веб-сайтам и брендам, и «черные» оптимзаторы очень хорошо используют это доверие. Например, некоторые мошеннические веб-сайты используют JavaScript, показывающий поддельное сообщение уведомления, якобы пришедшее из популярной социальной сети, портала или другого известного веб-сайта.

Клик по поддельному уведомлению приводит к специальным целевым страницам с формами подписки. Такая форма часто выглядит как всплывающий баннер поверх надежной страницы веб-сайта на заднем плане. Например, поддельное уведомление может содержать некоторую недействительную информацию о лотерее Яндекс и обещать призы, после которых пользователь видит форму мобильной подписки на фоне главной страницы Яндекса. Также используются фишинговые уловки. Все содержание загружается динамически, с использованием JavaScript-кода, который обычно обфусцируется. Другой тип целевых страниц может использовать вредоносный контент. Существует два главных вида атаки на пользователя в Сети: скрытая загрузка или социальная инженерия. Первый путь использует слабые места в браузере пользователя, плагинах или приложениях. В этом случае вирус обычно остается незамеченным. Второй подход основан на пользовательских страхах, жадности, отсутствии опыта или знаний. Это могут быть предложения бесплатно загрузить некое популярное программное обеспечение или «предупреждение безопасности» о необходимости обновления браузера (у такого подхода есть некоторое подобие с поддельным антивирусом [12]). Так или иначе, «черные» оптимизаторы получают возможность изменить системные настройки пользователя, изменить файлы, и т.д. В настоящее время мы наблюдаем вторую волну фарминга, когда hosts файл изменяется для имитации IP-адреса популярного веб-сайта. Должны признать, что, очевидно, наиболее прибыльными замены hostsведут на целевые страницы первого типа, которые монетизируются с помощью SMS-платежей или подписки. Процент успешных атак здесь выше, потому что для пользователя визуально ничто не изменяется. Имя популярного веб-сайта подменяетсяв поддельный IP-адрес, но строка поиска в браузере остается той же.

6. ВЫВОДЫ И БУДУЩИЕ ИССЛЕДОВАНИЯ

Современные методы SEO и веб-спама усложнились и стали более продвинутыми технологически. Это требует принятия немедленных действий от стороны поисковых систем. Системы обнаружения спама должны быть изменены с учетом широкого использования Javascript. Необходимы дополнительные ресурсы для интерпретации JS-кода и обнаружения соответствующих особенностей. Веб-спам имеет тенденцию сходиться с мошенничеством, так как это проявляется в широком применении взломанных сайтов, вредоносного программного обеспечения, ботнетов, фишинга и фарминга. Также широко используется социальная инженерия, которая заставляет ПСобращать внимание на образовательные проекты и услуги. Тем не менее, поисковые системы имеют большое влияние в Сети и продолжают успешно сопротивляться веб-спаму, сокращая количество отрицательных воздействий.

7. БЛАГОДАРНОСТИ

Авторы благодарят Сергея Пименова и Павла Сердюкова – ООО «Яндекс» – за их ценную помощь.

8. СПИСОК ЛИТЕРАТУРЫ

[1] J. Abernethy, O. Chapelle, and C. Castillo. Graph regularization methods for web spam detection. Machine Learning, 81(2):207–225, 2010.

[2] E. Agichtein, E. Brill, and S. Dumais. Improving web search ranking by incorporating user behavior information. Proceedings of the 29th annual international ACM SIGIR conference, pages 19–26,

[3] R. Alia and M. S. Beg. An overview of web search evaluation methods. Computers and Electrical Engineering, 37(6):835–848, November 2011.

[4] M. Erdelyi, A. Garzo, and A. A. Benczur. Web spam classification: a few features worth more. Proceedings of the 2011 Joint WICOW/AIRWeb Workshop on Web Quality, pages 27–34, 2011.

[5] A. Gulin and P. Karpovich. Greedy function optimization in learning to rank. Available at: http://clck.ru/8adNE, 2009.

[6] Y. Liu, M. Zhang, S. Ma, and L. Ru. User behavior oriented web spam detection. In Proceedings of the 17th international conference on World Wide Web, pages 1039–1040. ACM, 2008.

[7] K. Nikolaev, E. Zudina, and A. Gorshkov. Combining anchor text categorization and graph analysis for paid link detection. Proceedings of the 2009 International Conference on the World Wide Web, pages 1105–1106,

[8] J. Piskorski, M. Sydow, and D. Weiss. Exploring linguistic features for web spam detection: a preliminary study. Proceedings of the 4th international AIRWEB workshop, pages 25–28, 2008.

[9] F. Radlinski. Addressing malicious noise in clickthrough data. In Learning to Rank for Information Retrieval Workshop at SIGIR, 2007.

[10] S. Ragimova. Mobile bacchanalia. Kompaniya (in russian), 601, see http://clck.ru/8adNI, 2010.

[11] N. Spirin and J. Han. Survey on web spam detection: principles and algorithms. ACM SIGKDD Explorations Newsletter, 13(2):50–64, 2012.

[12] B. Stone-gross, R. Abman, R. A. Kemmerer, C. Kruegel, D. G. Steigerwald, and G. Vigna. The

underground economy of fake antivirus software. University of California at Santa Barbara, Economics Working Paper Series, 2011.

Вы дочитали статью! Отличная работа!

- В некоторых нюансах продвижения сайтов сложно разобраться без опыта. Вы можете доверить продвижение вашего сайта нам. Отправьте заявку и мы изучим ваш сайт и предложим эффективную стратегию продвижения вашего бизнеса в сети.

- Получите гайд для анализа конкурентов! Для вас мы собрали и упаковали в один документ полезные сервисы, которые сами используем в клиентских проектах.

- Понравилась статья? Поделитесь ссылкой на статью в социальных сетях - возможно, статья окажется полезной для ваших друзей и коллег.

- Хотите стать экспертом?

Предлагаем вам почитать другие наши статьи, вот некоторые из них:

- Ищете работу? Приглашаем вас в наш дружный и профессиональный коллектив: интересные задачи, перспективы профессионального и личностного роста, одна из самых опытных команд в области SEO-продвижения в Санкт-Петербурге. Наши вакансии.